网络爬虫中的402、403、404和429错误是什么?全面指南

Anh Tuan

Data Science Expert

12-Dec-2025

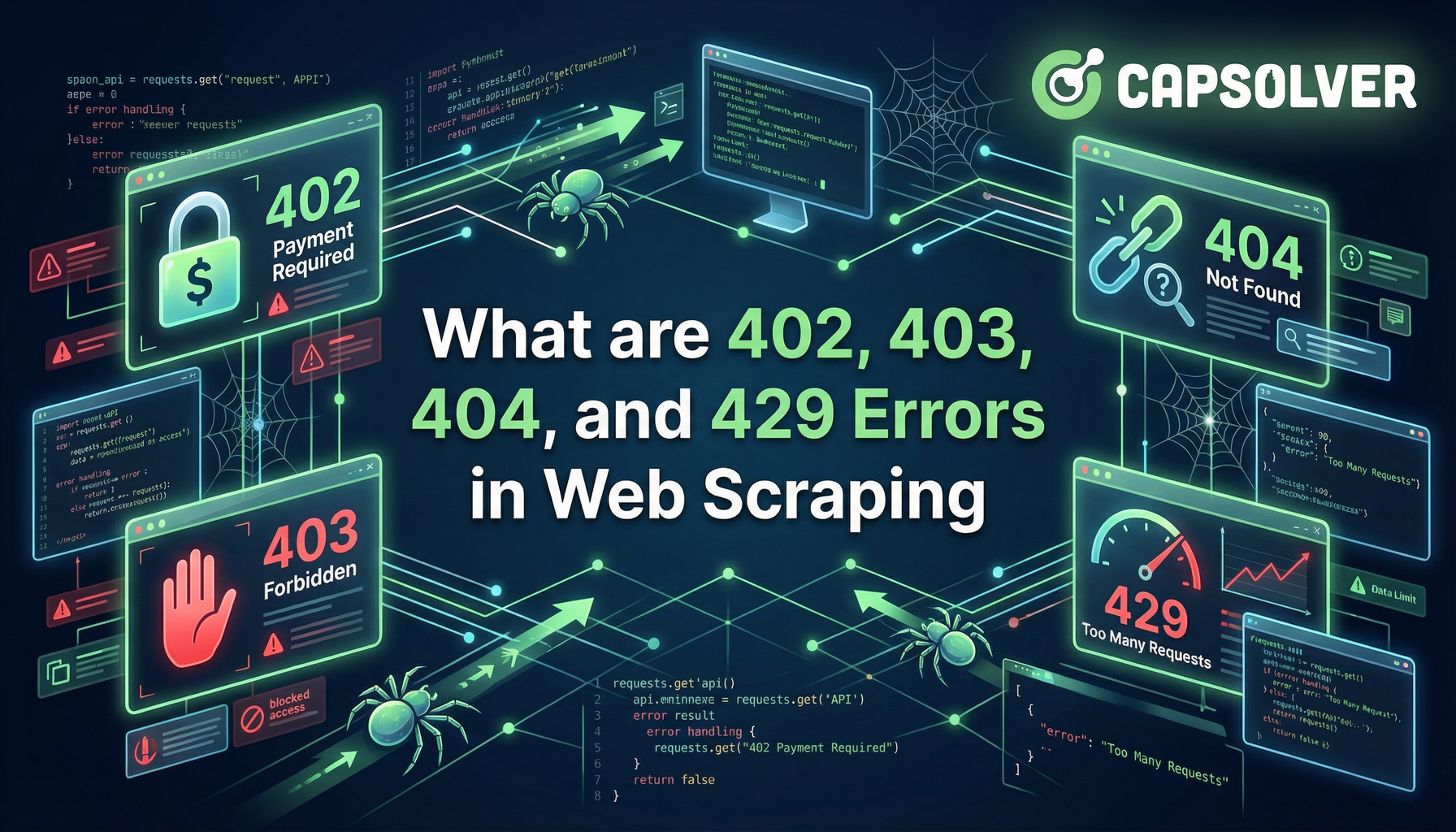

TL;Dr: 四个HTTP状态码—402(需付款)、403(禁止)、404(未找到)和429(太多请求)—代表了网络爬虫中常见的不同障碍。404错误是简单的资源问题,而403和429是服务器的主动防御机制。新兴的402错误表明自动化爬虫需要付费访问的新趋势。理解这些差异对于构建稳健且高效的爬虫基础设施至关重要。本文将解释网络爬虫中的402、403、404和429错误并提供可行的解决方案。

简介

网络爬虫是自动化从网站提取数据的过程。它是市场调研、价格监控和数据聚合的重要技术。然而,这种自动化活动经常遭到网站服务器的抵制。这些服务器使用网络爬虫的HTTP状态码来传达请求的结果。当请求失败时,服务器会返回错误代码。

本文深入探讨四个关键的客户端错误代码:402、403、404和429。我们将探索它们在网页爬虫中的具体含义、常见原因以及实用且稳健的解决方案。我们的目标是为您提供知识,构建能够应对这些挑战的爬虫。在本文结尾,您将清楚了解网络爬虫中的402、403、404和429错误以及如何克服它们。

404 未找到:简单的障碍

404 未找到错误是其中最简单的障碍。它表示服务器无法找到请求的资源。

定义与原因

404 未找到状态码意味着服务器正在运行且连接正常,但请求的特定URL并不对应任何现有资源。这不是对爬虫的主动阻止,而是目标网站结构问题或爬虫逻辑错误。这是每个网页开发者和爬虫都会遇到的基本错误。

常见原因:

- 损坏的链接: 您尝试爬取的URL已过时、拼写错误或被网站所有者永久删除。

- 爬虫逻辑错误: 您的脚本生成了错误的URL,可能是由于分页循环有误或相对链接提取出错。

- 动态内容变化: 网站结构发生变化,资源路径不再有效。这通常发生在网站重新设计或淘汰旧内容时。

解决方案与案例分析

处理404错误主要是关于数据清洁和稳健的URL管理。一个相关的关键概念是301(永久重定向)或302(临时重定向)状态码。如果页面已移动,服务器应返回301,引导您的爬虫到新位置。然而,404意味着资源确实不存在了。

| 解决方案 | 描述 |

|---|---|

| URL验证 | 在爬取之前验证URL格式。实现检查以确保URL结构正确并符合目标网站的惯例。 |

| 错误日志与分析 | 记录所有404错误及其对应的URL和引用页面。这有助于识别模式并修复坏链接的来源,这对维护数据质量至关重要。 |

| 检查站点地图和robots.txt | 将目标URL与网站的站点地图(如果可用)交叉核对,确保它们仍然有效。同时检查robots.txt确认路径未被有意禁止。 |

| 重试并跟随重定向 | 确保您的爬虫库配置为自动跟随301和302重定向。如果仍返回404,则链接确实已失效。 |

案例分析:电商平台产品监控

一个监控产品价格的爬虫突然开始收到大量404错误。调查发现该公司归档了旧产品页面但没有设置重定向。解决方案是更新爬虫逻辑,在旧页面上检查“产品已归档”信息后再记录404错误,从而避免误报并提高数据准确性。这一情况说明了解网络爬虫中的402、403、404和429错误是可靠数据提取的基础。

403 禁止:主动拒绝

403 禁止错误表明网站已识别您的爬虫并主动拒绝访问。服务器理解请求但拒绝执行它。

定义与原因

403 禁止状态码意味着客户端没有访问内容的必要权限。在网页爬虫中,这几乎总是网站防护措施的结果。服务器判断您的请求来自自动化脚本而非合法的人类用户。这是您会遇到的最常见的主动阻止形式。

常见原因:

- 缺失或恶意用户代理(User-Agent): 最常见的原因是缺失或通用的用户代理头。网站会阻止没有真实浏览器用户代理的请求。

- IP黑名单: 您的IP地址因激进的爬取行为被标记并禁止。

- 高级机器人检测: 服务器运行着复杂的机器人检测软件(如Cloudflare或Akamai),检测非浏览器自动化指纹,例如缺少JavaScript执行或特定头信息不一致。这通常会导致403或验证码挑战。更多相关内容,请阅读我们的指南如何解决网络爬虫中的验证码问题。

解决方案与实用技巧

克服403错误需要让您的爬虫更像人类。这正是您的爬虫设置技术复杂度的真正考验。您需要了解如何有效修复爬虫中的403禁止错误。

| 解决方案 | 描述 |

|---|---|

| 轮换用户代理(User-Agent) | 使用一组真实且更新的浏览器用户代理,并在每次请求中轮换。确保用户代理与您模拟的浏览器指纹匹配。 |

| 高质量代理轮换 | 实现可靠的住宅或移动代理网络来轮换IP地址。这可以防止单个IP被黑名单,并模拟来自不同位置的真实用户流量。 |

| 处理头信息和指纹 | 发送完整的现实HTTP头信息,包括Accept、Accept-Language和Referer。对于高级网站,考虑使用无头浏览器(如Playwright或Puppeteer)来执行JavaScript并通过客户端指纹检查。 |

| 解决验证码 | 当403与验证码挑战相关时,使用专门的服务如CapSolver自动解决挑战并获取访问令牌。这是克服复杂阻止的高效方法。您也可以在我们的文章爬取网站时解决403禁止错误中找到更多相关信息。 |

案例分析:金融数据聚合

一个金融数据爬虫在几百次请求后持续遇到403错误。调查发现该网站使用JavaScript挑战验证浏览器。修复方法包括集成高质量的住宅代理网络并切换到Playwright以执行必要的JavaScript。这种组合加上每10次请求轮换一次用户代理,成功克服了阻止。了解网络爬虫中的402、403、404和429错误是第一步;实施这些高级解决方案是下一步。

429 太多请求:速率限制墙

429 太多请求错误是服务器在说:“放慢速度。”这是对单个客户端过多请求量的直接回应。

定义与原因

429 太多请求状态码表示用户在给定时间内发送了太多请求。这是一种速率限制机制,旨在防止服务器过载并确保所有用户的公平访问。与403错误不同,服务器不一定将您视为机器人,而是限制您的速度。

常见原因:

- 激进的请求速率: 请求发送得太快,通常在没有延迟的情况下连续发送。这是这种网络爬虫的HTTP状态码最常见的原因。

- 超过API限制: 如果您在爬取API,您可能已超过API文档中定义的每分钟或每小时允许的请求数。

- 缺少

Retry-After头: 服务器通常在429响应中包含Retry-After头,建议等待多久再重试。忽略此头会导致重复的429错误。

解决方案与实用技巧

429错误的主要解决方案是实施智能的节流和退避策略。目标是让您的请求模式显得零散且像人类。这是处理429速率限制错误的核心。

| 解决方案 | 描述 |

|---|---|

| 实施随机延迟(抖动) | 在请求之间引入随机的、类似人类的延迟(例如5到15秒之间的随机数)。避免固定且可预测的延迟,因为这些容易被反机器人系统标记。 |

遵守Retry-After |

始终检查并严格遵守429响应中的Retry-After头。这是服务器明确指示等待时间的指令。 |

| 指数退避 | 如果请求因429失败,等待一段时间后,下一次尝试时将等待时间翻倍,并在延迟中加入小的随机“抖动”。这称为指数退避,是处理临时服务器错误的标准做法。 |

| 分布式爬取 | 使用代理池将爬取负载分散到多个IP地址上。这通过让请求看起来来自不同用户来有效提高整体速率限制。 |

案例分析:新闻聚合器

一个新闻聚合器每分钟爬取多个来源,导致频繁的429错误。解决方案是实施动态延迟系统。脚本从5秒延迟开始。如果收到429错误,脚本会检查Retry-After头。如果头信息缺失,脚本会实施指数退避,延迟从10秒翻倍到最大60秒,然后切换到新代理。这种自适应方法稳定了爬取过程。了解网络爬虫中的402、403、404和429错误允许进行精确的自适应错误处理。

402 需付款:爬虫的未来

402 需付款错误是一个保留的HTTP状态码,通常在标准网页浏览中很少使用。然而,它在网络爬虫领域正逐渐成为付费访问的机制。

定义与原因

402 需付款状态码保留用于未来使用,旨在表明客户端必须付款才能访问资源。在网页爬虫的背景下,这种代码被Cloudflare等平台采用以实现“按爬取付费”模型。这是处理网络爬虫中的402需付款错误的一个关键发展。

常见原因:

- 按爬取付费模型: 网站所有者明确配置服务器以对自动化爬虫收费。这是将数据访问货币化而非阻止的商业决策。

- API积分耗尽: 您使用第三方API进行数据访问,订阅或积分余额已用完,触发API提供商的402响应。

解决方案与影响

402错误是一个商业问题,而非技术问题。解决方案是付款。这是从403和429错误的猫鼠游戏中的根本性转变。

| 解决方案 | 描述 |

|---|---|

| 订阅续费 | 如果错误来自API,续订您的订阅或购买更多积分。这是处理网络爬虫中的402需付款错误最简单的方式。 |

| 集成付款协议 | 对于使用新兴x402协议的网站,您的爬虫必须集成付款机制以自动支付所需费用。这需要新的技术集成层。 |

| 评估成本与价值 | 如果网站要求付款,您必须决定数据的价值是否值得成本。这需要明确的数据采集商业案例。 |

402错误的兴起,由Cloudflare的“按爬取付费”等倡议推动,表明一种转变。网站所有者从直接阻止(403)转向货币化自动化访问。了解网络爬虫中的402、403、404和429错误意味着认识到这一新的经济层面并相应调整策略。

演变的服务器防御格局

403和429错误的普遍性是爬虫与网站反机器人系统之间持续对抗的结果。现代机器人检测远远超出简单的IP检查。系统分析数十种浏览器和网络特征,称为“指纹识别”,以判断请求是否自动化。

导致错误的关键服务器防御技术:

- 行为分析(429): 监控速度、鼠标移动和点击模式。非人类速度会触发速率限制。

- 头部和指纹检查(403): 检测HTTP头部不一致、缺失JavaScript变量或已知的自动化标志(例如

webdriver属性)。 - 验证码挑战(403/429): 提供对人类简单但对机器人困难的挑战。这是对可疑行为的常见响应。

这种背景对于理解网络爬虫中的402、403、404和429错误至关重要。403和429不是随机的;它们是来自复杂防御系统的计算响应。因此,您的解决方案也必须同样复杂,超越简单的用户代理轮换,实现完整的浏览器模拟和专业服务。

402、403、404和429错误比较总结

为了明确区分这四个关键错误,下表总结了它们的含义、主要原因以及网络爬虫的最佳应对方案。这种比较突出了每个网络爬虫的HTTP状态码的独立性。

| 错误代码 | 状态名称 | 爬虫中的含义 | 主要原因 | 最佳解决方案 |

|---|---|---|---|---|

| 402 | 需要付款 | 访问需支付费用。 | 按次爬取模式或API积分耗尽。 | 集成支付机制或更新订阅。这是处理网络爬虫中402需要付款错误的解决方案。 |

| 403 | 禁止 | 服务器主动拒绝客户端的访问。 | 反爬虫检测、缺少User-Agent、IP黑名单、高级指纹识别。 | 代理轮换、User-Agent轮换、解决CAPTCHA。这是解决网络爬虫中403禁止错误的方法。 |

| 404 | 未找到 | 请求的资源不存在。 | 链接损坏、URL生成错误、结构变化。 | URL验证、修复爬虫逻辑、错误日志记录。 |

| 429 | 请求过多 | 客户端已超过服务器的速率限制。 | 请求过快、忽略Retry-After标头、缺乏随机延迟。 |

实施智能延迟、指数退避、代理分发。这些是429请求过多错误的解决方案。 |

403和429之间的区别尤为重要。403是质量限制(你看起来像机器人),而429是数量限制(你速度太快)。两者都需要复杂的处理方式,以确保爬虫操作的可靠性。

推荐工具:CapSolver

在面对403和429错误的主动防御时,尤其是涉及CAPTCHA挑战的情况,需要一个专业的解决方案。CapSolver是一个领先的旨在克服各种服务器防御机制的服务,包括复杂的CAPTCHA如reCAPTCHA和Cloudflare Turnstile。

CapSolver提供了一个API,允许您的爬虫将挑战解决过程外包。这比尝试内部解决这些挑战要可靠得多。通过集成CapSolver,您可以将持续的403错误或与CAPTCHA相关的429错误转换为成功的请求。例如,如果您正在与IP封禁作斗争,您可能会发现我们的指南如何在2025年使用验证码解决器时避免IP封禁非常有帮助。

为什么选择CapSolver?

- 高成功率:专业模型确保在解决最新版本CAPTCHA时具有高准确性。

- 速度快:快速响应时间减少爬虫工作流中的延迟。

- 集成方便:与流行的爬虫框架简单API集成。

领取CapSolver优惠码

立即提升您的自动化预算!

在充值CapSolver账户时使用优惠码 CAPN,每次充值可获得额外 5% 的奖励 —— 没有限制。

现在在您的CapSolver仪表板中领取。

.

当您的爬虫被阻止时,关于网络爬虫中的402、403、404和429错误的问题很快就会变成“我该如何绕过它们?”CapSolver为403和429场景提供了强大的解决方案。

结论与行动呼吁

成功应对网络爬虫的世界不仅仅需要编写代码,还需要深入了解服务器通信和反机器人策略。这四个错误——402、403、404和429——各自带来了独特的挑战。404是简单的数据错误,429是速度限制,403是直接拒绝,402是新的付费墙。

构建一个强大的爬虫意味着实施多层次的错误处理策略:

- 数据完整性 来应对404错误。

- 速率限制和退避机制 来处理429错误。

- 身份伪装(代理/IP) 和 验证码解决 来处理403错误。

不要让网站的保护措施阻碍您的数据收集工作。今天就升级您的爬虫基础设施。

准备好克服最严峻的服务器防御挑战了吗?

访问CapSolver网站了解他们的服务:CapSlover

立即通过访问CapSolver仪表板解决验证码并克服障碍:CapSlover 仪表板

关键要点

- 404 是资源未找到错误;请修复您的网址。

- 403 是主动阻止;使用代理、轮换User-Agent并解决验证码。

- 429 是速率限制;实施智能随机延迟和指数退避。

- 402 是付费墙;准备好为有价值的数据源付费。

- 成功的关键是多层次的策略,精准应对网络爬虫中的402、403、404和429错误。

常见问题(FAQ)

Q1: 402 需要付款错误在当今的网络爬虫中常见吗?

402错误目前并不普遍,但其使用正在增长,尤其是在Cloudflare等主要基础设施提供商推广“按次爬取”模式的情况下。这是爬虫必须注意的重要新兴趋势。虽然大多数错误仍然是403和429,但402表明数据访问将被货币化,而不仅仅是被阻止。

Q2: 如何在脚本中区分403和429错误?

区分两者对于正确的错误处理至关重要。429错误通常包含Retry-After标头,而403错误通常不包含。429通常是暂时的,通过减慢速度即可解决。403是持续的阻止,需要更改请求身份(User-Agent、IP)或解决挑战。这种知识是实现有效网络爬虫的HTTP状态码错误处理的关键。

Q3: 使用代理是否能保证避免403和429错误?

不,使用代理是必要但不充分的解决方案。代理可以帮助将请求分布在多个IP地址上,从而缓解IP黑名单(403)和速率限制(429)。然而,如果您的爬虫行为(例如请求头、速度、缺乏JavaScript执行)仍然看起来像机器人,您仍然会收到403错误。您必须将代理与真实的User-Agent和智能节流结合使用。这是解决网络爬虫中403禁止错误的综合方案的一部分。

Q4: 解决由验证码导致的403错误最有效的方法是什么?

最有效的方法是使用专门的验证码解决服务,如CapSolver。这些服务使用AI解决挑战,并返回验证码令牌,您的爬虫可以使用该令牌完成请求。这种方法比尝试内部实现验证码解决器要可靠得多。

Q5: 实施429请求过多错误解决方案的最佳实践是什么?

最佳实践包括结合多种技术:1)请求间的随机延迟(抖动)以模仿人类行为;2)指数退避以优雅地处理重复失败;3)尊重服务器提供的Retry-After标头。忽视这些信号会导致立即且持续的封锁。

合规声明: 本博客提供的信息仅供参考。CapSolver 致力于遵守所有适用的法律和法规。严禁以非法、欺诈或滥用活动使用 CapSolver 网络,任何此类行为将受到调查。我们的验证码解决方案在确保 100% 合规的同时,帮助解决公共数据爬取过程中的验证码难题。我们鼓励负责任地使用我们的服务。如需更多信息,请访问我们的服务条款和隐私政策。

更多

如何使用Botasaurus和CapSolver在Python中解决CAPTCHA(完整指南)

学习如何将Botasaurus(Python网络爬虫框架)与CapSolver API集成,以自动解决reCAPTCHA v2/v3和Turnstile。

Ethan Collins

15-Dec-2025

网络爬虫中的402、403、404和429错误是什么?全面指南

通过了解402、403、404和429错误来掌握网络爬虫的错误处理。学习如何修复403禁止错误,实施解决429错误的速率限制方案,并处理新兴的402支付所需状态码。

Anh Tuan

12-Dec-2025

使用Python的网络爬虫:2026年最佳策略

学习2026年的顶级Python网络爬虫技巧,包括处理动态JavaScript内容、管理认证流程、解决验证码、识别隐藏陷阱、模拟人类行为、优化请求模式以及在大规模爬虫项目中减少资源使用。

Anh Tuan

12-Dec-2025

避免网络爬虫被封禁及验证码破解方法

网络爬虫已成为从网站中提取数据的流行技术。然而,许多网站采用反爬虫措施,包括...

Rajinder Singh

11-Dec-2025

网页爬虫与网页抓取:本质区别

揭示网络爬虫与网页抓取的本质区别。了解它们各自的用途、10个强大的应用场景,以及CapSolver如何帮助绕过AWS WAF和CAPTCHA限制,实现无缝的数据采集。

Ethan Collins

09-Dec-2025

如何使用 Scrapling 和 CapSolver 解决验证码

Scrapling + CapSolver 支持通过 ReCaptcha v2/v3 和 Cloudflare Turnstile 绕过进行自动化抓取。

Ethan Collins

05-Dec-2025